При упоминании названия Nvidia первое, что приходит на ум, — это графические процессоры. Изначально они предназначались для ускорения визуальной обработки (видео и изображений). Однако GPU быстро продемонстрировали свою универсальность, оказавшись особенно мощными для самых разных вычислений, в том числе для тех, которые лежат в основе ИИ и криптографии.

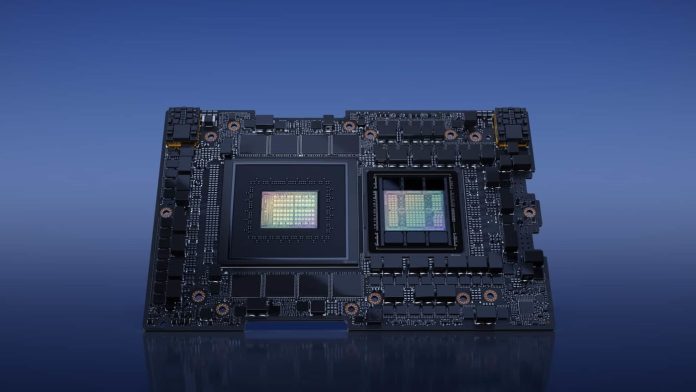

С ростом числа крупномасштабных моделей ИИ, включая большие языковые модели (LLM), спрос на вычислительные мощности резко возрос. Графические процессоры с их многочисленными ядрами способны выполнять бесчисленное количество вычислений одновременно. Поэтому не случайно, что такие эталонные тесты ИИ, такие как Bard от Google и ChatGPT от OpenAI, теперь опираются именно на эти технологии. В ответ на растущий спрос компания Nvidia, всегда находящаяся на переднем крае инноваций, только что объявила о выпуске своего последнего технологического чуда — чипа GH200 Grace Hopper.

Гигантский скачок вперед в области технологий памяти

Эта новая платформа Nvidia — первая в мире, в которой используется процессор HBM3e. HBM (High Bandwidth Memory) — это технология памяти, которая уже успела отличиться своей способностью обеспечивать исключительную пропускную способность при оптимизации энергопотребления. С версией HBM3e компания Nvidia открывает новые горизонты.

Микросхема памяти HBM3e, обладающая впечатляющей емкостью 282 ГБ, на 50% быстрее своей предшественницы HBM3. Столь значительное увеличение скорости приводит к росту производительности, способной обеспечить суммарную пропускную способность 10 ТБ/с. Это означает, что чип GH200 может работать с моделями искусственного интеллекта, объем которых в 3,5 раза больше, чем у технологии HBM3. Такая память также позволяет чипу работать со сверхсложными моделями искусственного интеллекта.

Кроме того, такой объем памяти означает, что крупномасштабная модель искусственного интеллекта может быть выполнена на одном GPU. Для достижения такого уровня производительности платформы обычно используют несколько GPU, что означает дополнительные затраты и сложность.

Суперчип, предназначенный для вычислений

Работа с искусственным интеллектом включает в себя два этапа: обучение и вывод. На первом этапе, этапе обучения, модель искусственного интеллекта получает информацию и «обучается» на огромных массивах данных. Именно на этом этапе модель обучается и совершенствует свои возможности.

После завершения обучения модель переходит в фазу вывода. На этом этапе модель испытывается на практике, генерируя прогнозы, текст, изображения или другие формы контента на основе полученных знаний. Каждый запуск программного обеспечения на основе ИИ, каждый прогноз или генерация требуют значительных вычислительных мощностей для вывода. И именно в этой области GH200 демонстрирует превосходство.

В ходе презентации компания Nvidia подчеркнула, что ее новый суперчип GH200 оптимизирован для вычислений в области выводов. Хотя эта операция часто бывает очень дорогостоящей, Nvidia утверждает, что GH200 позволит значительно снизить энергозатраты при использовании в больших моделях. Другими словами, с GH200 вычисления становятся не только быстрее, но и экономичнее.